Over testpeople

Software (automation) testers met kennis van agile testing en testautomatisering. Door écht samen te werken met onze opdrachtgevers, bieden wij advies op maat. En staat de mens achter een project centraal. Van ons mag je altijd een eerlijk antwoord verwachten.

Software testing

Testpeople detacheert 25 Test professionals door het hele land bij opdrachtgevers in verschillende branches. Denk hierbij aan: ASR, Obvion, Rabobank, Belastingdienst en de Koninklijke Bibliotheek. Onze software testers ondersteunen organisaties bij het testen van nieuwe of bestaande applicaties. Zo zorgen we er samen voor dat je applicatie voldoet aan de eisen en verwachtingen van je gebruikers. Onze mensen zijn niet alleen testers, maar ook consultants: communicatief sterk en eerlijk.

We hebben de volgende specialisten beschikbaar: Software Test Engineer, Test Automation Engineer, DevOps / Test Engineer, Agile Test Engineer en Test Consultant

Benieuwd naar wat wij zoal voor opdrachtgevers hebben gedaan? Lees dan onze klantcases!

Het team

Succesvol testen begint bij de mensen die het doen. Daarom draait het bij Testpeople in de eerste plaats om ‘people’. Naast het delen van kennis en samenwerken aan complexe projecten, maken we ook samen plezier tijdens co-workdagen, reizen naar het buitenland en gezellige borrels.

Met de voordelen van loondienst

Je start pas wanneer je écht enthousiast bent over de opdracht

En deelnemen aan leuke activiteiten

We bouwen echt een band op

We hebben oog voor de mens en de wereld

Diensten van testpeople

trainingen

Onze specialisten helpen en trainen jou en je team om hoogwaardige softwareproducten en -diensten op te leveren. Dit doen ze door een praktische en interactieve leerervaring aan te bieden. Dankzij de diversiteit van ons klantportfolio hebben wij ervaring met diverse branches.consultancy

Onze consultants zijn experts op het gebied van software testing en werken nauw samen met jouw team om oplossingen te implementeren die passen bij jouw specifieke behoeften en bedrijfsdoelen.kickstarters

Onze ervaren professionals bieden ondersteuning bij het ontwikkelen van nieuwe teststrategieën en kunnen aanbevelingen doen om de efficiëntie en productiviteit van jouw testteam te verbeteren.assessments

Onze assessments bieden inzicht in de kwaliteit van jouw softwareproducten en -diensten. We voorzien je van concrete aanbevelingen.Samenwerken?

Wil je met ons samenwerken of wil je meer weten over onze diensten? Neem contact op met Koen, hij helpt je graag!

Koen Dorsteen

Werken bij testpeople

Werk je bij Testpeople, dan start je pas bij een opdracht wanneer je echt enthousiast bent. Wij gaan op zoek naar een opdracht die bij je past en in lijn is met je ontwikkelingswens. We denken met je mee over je korte en lange termijn pad en timmeren samen met jou aan de weg. Je bepaalt zelf of en wanneer je een training wil volgen en we denken altijd graag met je mee.

Wij komen regelmatig samen om kennis te delen tijdens co-work dagen en gildes. Daarnaast organiseren wij ook uitjes om samen plezier te maken. Denk aan een trip naar Berlijn of een Game-night. Jij bepaalt bij welke events je aansluit, geen verplichtigen 😊.

Bekijk hier onze vacatures op het gebied van testen:

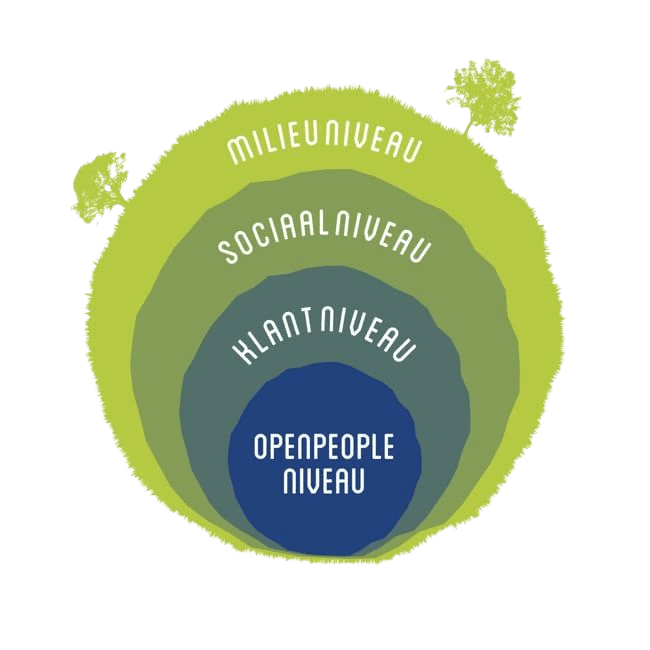

Openplanet

Alles wat we bij Openpeople doen om iets te betekenen voor anderen en de wereld, delen we onder de noemer Openplanet. Van delen tot doneren. Minimaal 10% van onze winst gaat naar Openplanet-initiatieven, waar we ons met een eigen werkgroep elke maand voor inzetten.